- 冯·诺依曼体系 是我们目前所有通用计算机(包括运行AI的电脑)的“身体”和“神经系统”,它定义了信息如何存储、处理和传输。

- 人工智能 是我们想让这个“身体”去执行的“高级智慧任务”,比如思考、学习、推理和创造。

下面我们从几个方面来详细解析。

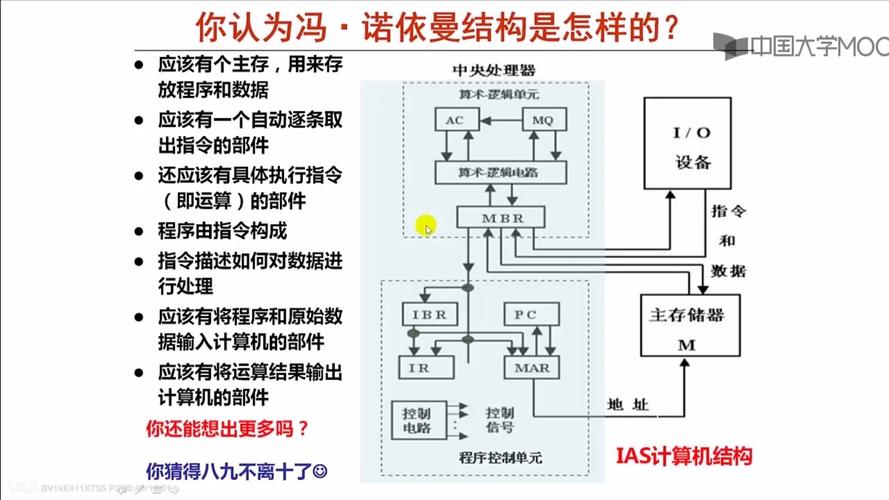

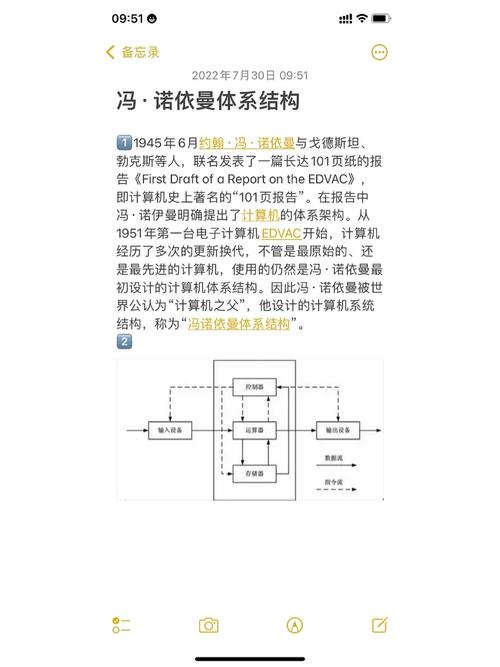

什么是冯·诺依曼体系?

冯·诺依曼体系结构是1945年由约翰·冯·诺依曼等人提出的一个计算机设计蓝图,它定义了现代计算机的基本工作原理,其核心思想可以概括为“存储程序”概念。

核心特点:

-

五大部件:计算机由五个基本部分组成:

- 运算器:执行算术和逻辑运算。

- 控制器:指挥和协调计算机各部件工作,从内存中读取指令并执行。

- 存储器:存放数据和程序指令。

- 输入设备:将外部信息(如键盘、鼠标输入)送入计算机。

- 输出设备:将计算结果(如显示器、打印机输出)展示给用户。

-

存储程序:这是最关键的一点。程序指令和数据以二进制形式一同存储在同一个内存中,计算机启动后,控制器会按照顺序从内存中取出指令并执行,这就是所谓的“取指-执行”循环。

(图片来源网络,侵删)

(图片来源网络,侵删) -

以CPU为中心:所有数据流动都必须经过CPU,数据从内存到CPU进行处理,处理结果再写回内存,这个过程被称为“冯·诺依曼瓶颈”(Von Neumann Bottleneck)。

一个生动的比喻: 冯·诺依曼体系就像一个“图书管理员”。

- 图书馆 = 内存,存放着所有“书”(数据)和“操作手册”(程序指令)。

- 图书管理员 = CPU,他负责阅读手册(取指令),然后根据手册上的指示去书架(内存)上取书、处理书中的内容(运算),最后再把处理好的内容放回书架。

- 瓶颈在于,管理员每次只能做一件事:要么看书,要么去书架取书,不能同时进行,他必须亲自往返于自己的办公桌和书架之间,这个往返过程就是瓶颈。

冯·诺依曼体系如何支撑人工智能?

我们今天所熟知的大多数AI,尤其是深度学习,都是在冯·诺依曼体系结构的计算机上运行的。

- 数据存储:海量的训练数据(图片、文本、声音)都存储在冯·诺依曼体系的内存和硬盘上。

- 程序运行:AI模型的核心算法,如神经网络的前向传播和反向传播,被编写成程序(例如用Python和TensorFlow/PyTorch框架),这些程序作为指令序列也存储在内存中。

- 计算执行:CPU(或更常见的GPU)作为运算器,执行这些指令,进行大量的矩阵乘法和加法运算,从而完成模型的训练和推理。

可以说,没有冯·诺依曼体系提供的通用、可编程的计算平台,现代AI的繁荣是不可想象的。 它为AI算法提供了一个灵活的舞台,我们可以在上面运行各种各样的程序,而不仅仅是固定的功能。

冯·诺依曼体系成为AI发展的瓶颈

尽管冯·诺依曼体系是AI的基石,但它的内在结构也严重限制了AI,特别是深度学习的发展,这种限制主要源于“冯·诺依曼瓶颈”。

瓶颈的具体表现:

-

数据搬运成本高昂:深度学习的核心是计算密集型和数据密集型的,它需要GPU在极短时间内处理海量数据,GPU的计算单元(运算器)和数据(存储在内存中)被物理上分开,每次计算,数据都必须通过狭窄的总线从内存搬运到GPU,计算完成后再搬运回去,这个过程消耗的时间和能量,远超实际计算本身所占用的,这就像图书管理员大部分时间都花在了跑腿上,而不是真正阅读和处理书籍。

-

能效低下:为了缓解瓶颈,现代CPU/GPU的晶体管数量越来越庞大,但大部分晶体管都用于高速缓存和复杂的内存控制器,用于管理数据流动,而不是用于纯粹的运算,这导致了巨大的功耗,训练一个大型AI模型(如GPT-3)消耗的电力相当于一个小城市数月的用电量,其大部分能量都消耗在了数据搬运上,而非智能计算本身。

-

并行度受限:AI,尤其是神经网络,本质上是高度并行的任务,但冯·诺依曼体系是“指令驱动”的,程序需要一条一条地顺序执行(即使有多核,也是宏观上的并行),虽然GPU通过成千上个小核心实现了数据并行,但它们仍然需要等待中央控制器(或驱动程序)下发指令和数据,无法充分发挥硬件的全部并行潜力。

一个形象的比喻: 想象一个世界顶级的厨师(GPU),他的刀工和火候(计算能力)无与伦比,他的厨房(冯·诺依曼体系)设计得很糟糕,所有的食材(数据)都储存在一个遥远的、需要上锁的储藏室(内存)里,他每次切菜(计算),都必须停下手中的活,跑到储藏室门口等服务员(总线)拿食材,然后再跑回来,即使他的刀再快,大部分时间也浪费在了往返跑腿上,整体效率极低,而且累得满头大汗(高能耗)。

突破瓶颈:非冯·诺依曼计算与存内计算

为了解决冯·诺依曼瓶颈对AI的制约,学术界和工业界正在积极探索“非冯·诺依曼体系结构”,其中最热门、最被看好的就是“存内计算”(In-Memory Computing, 或称存算一体)。

存内计算的核心思想: 将计算单元直接集成在存储单元内部,让数据在存储的地方直接进行计算,彻底消除数据搬运的需求。

继续用厨师比喻: 存内计算就像是为这位顶级厨师打造了一个“智能厨房”,每个食材架(存储单元)本身就是一个微型工作站,自带刀具和灶台(计算单元),当厨师需要处理某样食材时,食材会自动在它自己的架子上完成预处理、切割和烹饪,处理好的半成品再直接递给下一个环节,厨师(中央控制器)只需要统筹规划,不再需要亲自搬运食材,效率得到了指数级的提升。

存内计算的优势:

- 超高能效:由于数据不再需要长途跋涉,能耗可以降低几个数量级。

- 超高速度:计算延迟大大降低,数据处理速度更快。

- 天然并行:每个存储单元都可以独立工作,非常适合AI这种大规模并行任务。

实现方式: 目前主要有几种技术路线,如:

- 基于忆阻器:一种新型的电子元件,它既是存储器又是电阻器,非常适合模拟神经网络的突触权重。

- 基于SRAM/DRAM:在传统存储芯片中集成计算晶体管,实现“计算在内存中发生”。

- 基于光子计算:利用光子进行数据传输和计算,速度更快,能耗更低。

| 特性 | 冯·诺依曼体系 | 非冯·诺依曼体系 (以存内计算为例) |

|---|---|---|

| 核心思想 | 存储程序,计算与存储分离 | 计算与存储融合 |

| 数据流 | 数据在CPU和内存间来回搬运 | 数据在存储原地计算 |

| 瓶颈 | 冯·诺依曼瓶颈(数据搬运) | 技术成熟度、制造成本、编程模型 |

| 能效 | 较低,大部分能耗在搬运 | 极高,专为高效计算设计 |

| 适用场景 | 通用计算,逻辑复杂任务 | 大规模并行计算,如AI、大数据分析 |

| 当前状态 | 绝对主流,AI运行的底层平台 | 前沿研究,被视为下一代AI计算的希望 |

冯·诺依曼体系是过去几十年信息革命的基石,它孕育了今天的人工智能,随着AI对算力和能效的需求越来越高,冯·诺依曼体系固有的瓶颈已成为其发展的“天花板”。

未来的趋势很可能是“混合架构”:

- 在可预见的未来,冯·诺依曼体系仍将是通用计算的主流。

- 但在特定的、对算力和能效要求极高的领域(如AI加速器、数据中心),存内计算等非冯架构将扮演越来越重要的角色,作为协处理器与主CPU协同工作。

我们正在从一个“通用计算”的时代,迈向一个“专用智能计算”的时代,而这一切,都是为了更好地服务于人工智能的终极目标。

标签: 冯诺依曼体系 人工智能架构 人工智能 冯诺依曼瓶颈 冯诺依曼 人工智能计算模型